Se mi chiedessero di definire con una sola frase la post-produzione, direi che è una libera reinterpretazione delle informazioni contenute in una fotografia. Talvolta modifica l’immagine in maniera minimale, altre volte ha un impatto simile a quello di una bomba, ma è comunque una reinterpretazione. È reinterpretazione la creazione di una versione in bianco e nero così come un taglio, la rimozione di un brufolo o la modifica di un colore. Senza entrare nell’etica di quanto sia “troppo” in questo campo, questi sono i confini del campo da gioco.

Nell’articolo precedente ho messo in evidenza due possibili approcci alla post-produzione, più un terzo non-approccio che dilaga soprattutto sui social network. Esiste anche un polo di puristi che rifiutano la post-produzione per ragioni filosofiche e affermano che la fotografia è solo quella prodotta dalla fotocamera, così come sta. Vorrei dimostrare che questa affermazione è priva di senso oggi così come lo era anche ai tempi della pellicola, e spiegare perché non può esistere un’immagine non post-prodotta.

La demosaicizzazione demistificazione del formato RAW

Un dato di fatto: qualsiasi fotografia digitale nasce in formato RAW, anche quando la fotocamera produce un file JPEG. La produzione di un JPEG (o meglio, di un’immagine raster) è necessaria perché i dati RAW non sono direttamente fruibili. Mi è peraltro capitato spesso di leggere che ciò che appare nell’anteprima di Camera Raw o di Lightroom quando i parametri sono tutti “a zero” è l’immagine RAW non sviluppata: Dante Alighieri classificherebbe questa affermazione tra i difettivi sillogismi citati nel canto XI del Paradiso. Anzi, questa è un’affermazione del tutto errata che dimostra quanto poco si sia compreso in media sulla natura dei dati RAW.

Non dobbiamo trascurare un assunto di fondo: un’immagine digitale, RAW o raster che sia, in senso stretto è invisibile per definizione. Diventa visibile solo nel momento in cui la rappresentiamo su un monitor o su un supporto stampato. La rappresentazione può essere buona o meno, accurata o meno, ma è tutto ciò che possiamo vedere: un’immagine digitale di per sé è soltanto una lista di numeri che definiscono quale aspetto dovrebbero avere i pixel che la compongono. Possiamo leggere quei numeri ad alta voce, ma non immaginare l’aspetto dell’immagine mentre lo facciamo.

L’anteprima di Camera Raw o Lightroom è un’immagine già sviluppata, ma non ancora pronta a entrare in Photoshop. Quando modifichiamo un parametro come Esposizione o Temperatura, non interveniamo sui dati RAW grezzi ma su dati già in buona parte decodificati. In particolare, dati che hanno già subito il processo di demosaicizzazione, o non saremmo in grado di vedere alcun colore. I dati RAW riflettono il numero di fotoni che hanno colpito i fotositi del sensore nel corso dell’esposizione. In termini tecnici, se non ci fosse di mezzo il filtro di Bayer corrisponderebbero con la registrazione della luminanza della scena ripresa. La presenza del filtro complica le cose, ma è essenziale per codificare il colore, escludendo sensori particolari come il Foveon.

L’aspetto dei dati RAW

Se prendiamo i dati RAW e li rappresentiamo assegnandogli una luminosità proporzionale al loro valore numerico, otteniamo un’immagine simile a questa (qui molto ingrandita):

La prima osservazione è che l’immagine è quadrettata: I quadretti rappresentano la struttura a mosaico del filtro di Bayer. La seconda è che è priva di colore. Ciascun fotosito codifica una sola componente cromatica: rossa, verde o blu, a seconda del colore del filtro che lo ricopre. Un fotosito, però, non sa cosa sia il colore: si limita a contare fotoni, e i fotoni sono tutti uguali. Non sono intrinsecamente rossi, verdi o blu. Se a titolo di esempio assegnassimo ai pixel contenenti i dati dei singoli fotositi il colore corrispondente a ciascun filtro del mosaico che lo ricopre, il primissimo piano di una bocca apparirebbe così:

A scanso di equivoci, questa immagine non è e non sarà mai visibile in Camera Raw, perché è pre-sviluppo, e Camera Raw non mostra mai dati RAW non sviluppati. Non è neppure semplice da ottenere, e ho utilizzato un’utility specializzata che non ha alcuna utilità in fase di produzione. Il colore di questa immagine non ha corrispondenza con la realtà: è una colorazione di comodo utile a mostrare la vera struttura di un’immagine RAW.

Per vedere il colore così come lo intendiamo, bisogna rimuovere il mosaico con un’operazione chiamata demosaicizzazione che può essere condotta in vari modi. Se pensiamo alla struttura del filtro di Bayer, un’immagine RAW contiene soltanto il 25% dei dati relativi ai canali del rosso e del blu e il 50% dei dati relativi al canale del verde. Complessivamente, mancano ben due terzi dei dati complessivi che formano l’immagine finale: questa enorme quantità d’informazione viene generata per mezzo di interpolazioni sui valori dei pixel realmente esistenti. La demosaicizzazione, in sostanza, è la creazione di una grandissima quantità d’informazioni dal nulla. Girando la frittata, il 75% dei dati dei canali del rosso e del blu in un’immagine raster non provengono da dati reali, ma sono stati calcolati; lo stesso vale per il 50% dei dati del verde.

A questo punto, il JPEG

Quando scattiamo in JPEG, perché lo decidiamo noi o perché la fotocamera non offre la possibilità di salvare un RAW, l’immagine nasce comunque in RAW e viene processata; i dati RAW vengono poi immediatamente scartati. Il processo avviene all’interno della fotocamera: viene messa in atto la demosaicizzazione seguita da una serie di passi che, alla fine, producono un’immagine raster visualizzabile su qualsiasi dispositivo. Si tratta di un vero e proprio sviluppo e avviene in tempo pressoché reale. Anche l’anteprima che vediamo nel visore della fotocamera è un’immagine raster in miniatura tratta dai dati RAW e sviluppata secondo certi criteri.

Possiamo influire su questo sviluppo in vari modi. Il più intuitivo è l’impostazione del bilanciamento del bianco, che è irrilevante quando lavoriamo in RAW ma influenza pesantemente l’aspetto di un JPEG. I parametri a nostra disposizione sono comunque diversi, e si traducono nelle impostazioni di fotocamera che nel mondo Canon si chiamano Picture Style e in quello Nikon Picture Control. Scegliere a priori una di queste impostazioni quando si produce un file JPEG è, a tutti gli effetti, una scelta preventiva di post-produzione. Anomala, se vogliamo, perché la effettuiamo prima ancora dello scatto, ma questo non è così assurdo come sembra. Potremmo forse chiamarla una pre-produzione? È un problema linguistico, ma comunque sia prendiamo delle decisioni importanti su quello che sarà l’aspetto dell’immagine.

Per capire perché non abbia senso parlare di immagini non post-prodotte, torniamo indietro di mezzo secolo e analizziamo una specifica fotografia.

La stampa nella busta arancione

Mio padre aveva una camera oscura in casa. Quando ero bambino, in essa c’erano diverse buste che contenevano stampe rimaste fuori dagli album di famiglia. Una di queste mi affascinava moltissimo: era un ritratto in bianco e nero della mia bisnonna, mancata quando io ero quasi appena nato. Era 30 x 40 cm, su carta opaca, e stava in una grande busta di colore arancione intenso con il marchio Agfa in bella vista.

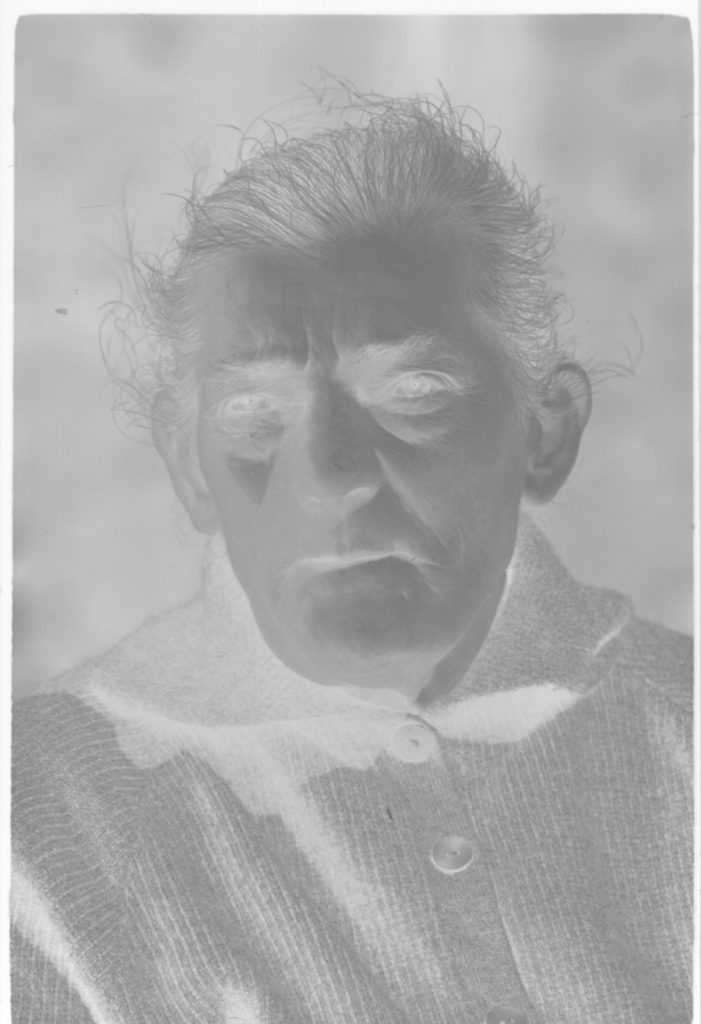

Molti anni dopo ho recuperato il negativo e l’ho scansionato. La pellicola era una ADOX KB14: 35 mm e una sensibilità di ISO 20. Non so come fu sviluppata, ma di certo la fotografia venne scattata con una fotocamera manuale Edixa Mat Reflex. La scansione, effettuata nella maniera più lineare possibile compatibilmente con le impostazioni del mio scanner, è questa.

Non è necessario leggere i valori dell’immagine per comprendere che siamo ben distanti dal massimo annerimento possibile. Si vede bene, anche guardando il negativo originale, che nessuna area è chiusa o bruciata: il dettaglio è preservato ovunque. Questo è il segno di una gamma dinamica sufficientemente ristretta nella scena originale. Non posso a priori dire se l’esposizione sia stata ottimale, né quale effetto abbia avuto lo sviluppo chimico sul risultato, perché non conosco questi dati. Quello che è certo è che ogni parte della fotografia è recuperabile. Ritagliato il bordino bianco che delimita i margini del negativo e invertita l’immagine, il risultato non fa particolarmente impressione.

Questa fotografia non assomiglia minimamente a quella custodita nella busta di cartone: la stampa è ricca di transizioni tonali, ha un ottimo contrasto ed è incisiva. All’epoca non esisteva Photoshop: se il negativo è così piatto, come fece mio padre a realizzare quella stampa?

Ottimizzare la gamma dinamica

Il primo parametro da tenere in considerazione era la gradazione della carta, di norma indicata da un numero compreso tra 1 e 5. A numeri più alti corrispondeva una carta in grado di fornire maggiore contrasto. Il secondo parametro era l’esposizione della carta sotto l’ingranditore. Si realizzava un provino utilizzando tempi di esposizione diversi e si sceglieva la versione preferita dopo averlo sviluppato in condizioni il più possibile vicine allo standard raccomandato per quella carta e lo specifico bagno di sviluppo utilizzato. In base a quella scelta, si stampava la versione definitiva. Era possibile sostituire la carta utilizzata con una di gradazione più bassa o più elevata, nel caso il contrasto non fosse soddisfacente, e questo di norma non influenzava il tempo di esposizione.

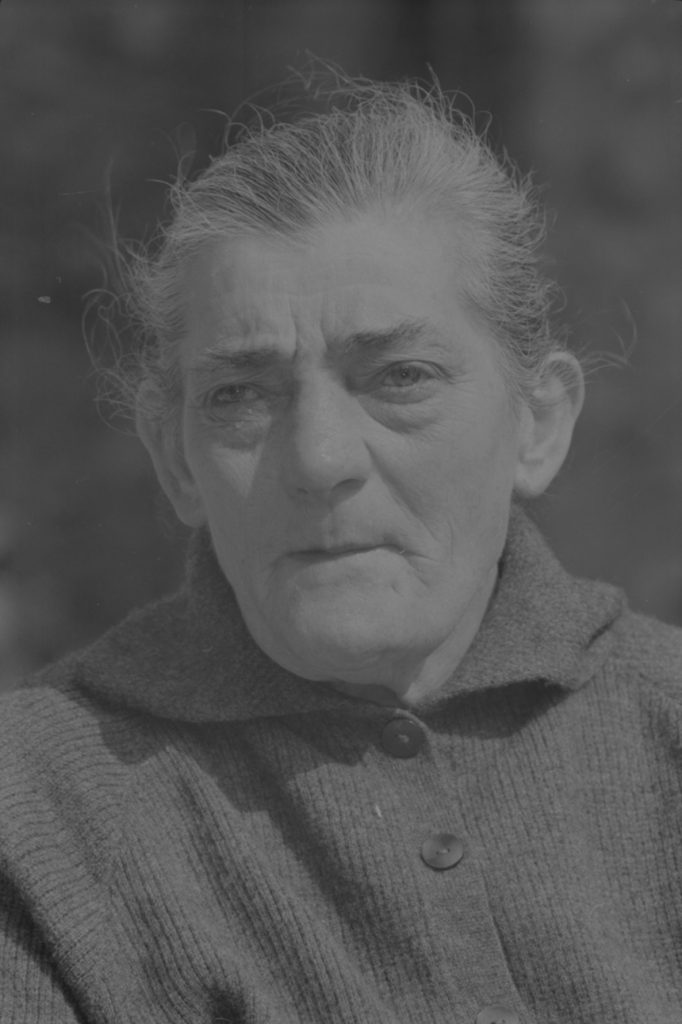

Lavorare su una versione digitale dell’immagine è assai meno laborioso. Anche l’operatore meno esperto di Photoshop conosce il comando Tono automatico nel menu Immagine. Un semplice clic produce miracoli su fotografie piatte e senza vita come questa.

In realtà non c’è nulla di miracoloso: Photoshop analizza l’immagine individuandone le aree più scure e più chiare; nel caso che le stesse abbiano valori non abbastanza vicini al nero e al bianco rispettivamente, espande i toni di grigio fino a che occupano tutto l’intervallo a disposizione. In questo caso, l’area più scura coincide con l’ombra della maglia visibile in prossimità dell’angolo in basso a sinistra; quella più chiara cade sulla fronte, a destra per noi che guardiamo, in prossimità dell’attaccatura dei capelli. Non a caso, quelle aree sono diventate praticamente “nera” e “bianca” rispettivamente.

Uno stampatore tradizionale avrebbe seguito un percorso diverso: avrebbe scelto il tempo di esposizione in modo da ottenere luci molto chiare e ombre molto scure a partire dal negativo. La distribuzione dei grigi tra questi due estremi dipendeva dalla scelta della gradazione. Era anche possibile intervenire con tecniche di mascheratura manuale che sono facilmente replicabili in Photoshop con strumenti come Scherma e Brucia.

In sintesi, quando mio padre scattò la fotografia ottenne un’immagine latente, ancora non sviluppata, dalla quale non poteva tornare indietro. È l’equivalente di ciò accade oggi quando noi scattiamo una fotografia digitale e ne immagazziniamo i dati in un file RAW. In pellicola venivano comunque messe in atto delle scelte di post-produzione, talora implicite: lo sviluppo ottenuto con un rivelatore Kodak HC 110 molto concentrato sarebbe stato ben diverso da quello fornito dal Kodak Microdol-X. La prima versione sarebbe stata più contrastata e sgranata, la seconda più ricca di transizioni tonali e a grana molto più fine. Da questo punto di vista, lo sviluppo del RAW è una benedizione: a differenza di quanto avveniva con la pellicola, possiamo realizzare tutti gli sviluppi che vogliamo partendo dai dati immagazzinati nel file, che rimangono intatti. Nella fotografia tradizionale, una volta che la pellicola era sviluppata non c’era ritorno: la scelta del rivelatore era, di fatto, post-produzione. Idem la scelta della gradazione della carta e del tempo di esposizione della stampa.

Photoshop è intelligente?

La domanda è se la versione realizzata da Photoshop con il comando Tono automatico sia la migliore possibile. La risposta è no.

Questa versione appare più contrastata della precedente, pur senza risultare eccessiva. Vale la pena di vedere le due versioni affiancate: a sinistra, quella realizzata dall’intelligenza artificiale di Photoshop; a destra, quella realizzata dalla povera intelligenza del sottoscritto.

Se chiedeste a un gruppo di fotografi quale differenza notano tra le due versioni, quasi tutti risponderebbero che quella di destra è più contrastata. In senso assoluto, non è vero: nella versione di sinistra i punti di ombra e di luce sono rispettivamente più scuro e più chiaro. Globalmente, la versione di destra ha meno contrasto. È vero però che ha maggiore contrasto nel volto: i lineamenti sono più incisi, si notano meglio i dettagli e in generale è migliore la caratterizzazione della persona. Non tutto è migliorato, però: la maglia ha transizioni tonali meno marcate; lo sfondo pure. Ma non conta: per una volta il soggetto è chiaro – è il volto a interessarci, non la maglia o lo sfondo. Ben venga quindi il contrasto nel soggetto, a discapito del resto.

Il motivo per cui Photoshop non riesce da solo a dare abbastanza contrasto al volto è che non sa cosa sia un volto. Per farlo, io ho osservato che il viso cade in un’area tonale ben definita, e ho realizzato una curva per contrastare quell’area. Quello che per me è il viso della mia bisnonna, per Photoshop è un ammasso di pixel: non può sapere se siano importanti o meno nel contesto della fotografia. Da quel punto di vista, la mia scelta è più educata di quella che il software è in grado di realizzare, e la differenza si nota.

In che zona siamo?

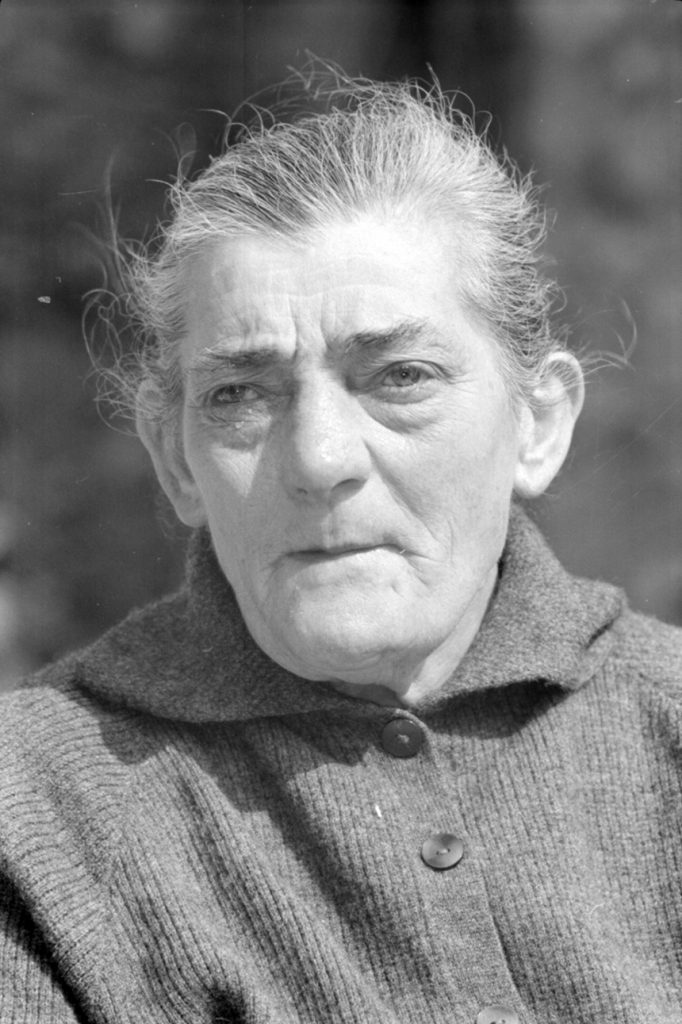

A questo punto, vorrei fare una cosa poco ortodossa. Visto che abbiamo individuato tre aree precise (volto, maglia, sfondo), potremmo chiederci in quale rapporto tonale medio stanno tra loro. Per scoprirlo, basta realizzare tre selezioni approssimate, calcolare la media dei pixel che contengono (Filtro -> Sfocatura -> Media) e dare un’occhiata ai valori di grigio che le aree assumono. La mia versione dà questo risultato:

I tre toni di grigio che vediamo rappresentano la media dei pixel delle tre aree. Se leggiamo il loro valore in Lab, la chiarezza (L) risulta essere:

Sfondo: L = 27

Maglia: L = 45

Volto: L = 65

Cosa avrebbe detto Ansel Adams?

Considerando le undici divisioni previste dal sistema zonale, lo sfondo si avvicina alla Zona III, la maglia vive tra le zone IV e V, il volto tra le zone VI e VII. In media, naturalmente: ci sono ombre praticamente in zona 0 e aree del volto vicinissime alla zona X. Non abbiamo alcuna necessità, di solito, di fare questa considerazione, ma in questo caso è utile perché la stessa operazione effettuata sul negativo invertito non post-prodotto fornisce un risultato istruttivo:

Sfondo: L = 29

Maglia: L = 37

Volto: L = 46

Lo sfondo cade praticamente in Zona III, la maglia si avvicina alla Zona IV, il volto alla Zona V. In media, la fotografia si articola a cavallo di tre zone soltanto. Nel caso della versione post-prodotta, le zone sono cinque. La differenza di chiarezza media nell’originale ammonta a soli 17 punti; nella versione post-prodotta arriva a 38 punti – più del doppio. Lo scopo della post-produzione di base è proprio questo: ottimizzare la distribuzione dei valori tonali sfruttando al massimo il supporto che abbiamo a disposizione. Potremmo mantenere il volto più chiaro, ma perderemmo contrasto; o potremmo rendere la maglia più scura, ma probabilmente il suo aspetto diventerebbe presto innaturale. In ogni caso, solo il gusto suggerisce dove fermarsi. A prescindere da questo, quello che abbiamo fatto è la versione digitale di ciò che avrebbe messo in atto uno stampatore per ricavare un’immagine guardabile: abbiamo alterato la distribuzione tonale.

Quindi, se scattiamo in JPEG?

È sensata l’affermazione di chi sostiene di costruire la fotografia finale esclusivamente in macchina, senza interventi a posteriori? Non lo era nella fotografia tradizionale, come abbiamo visto. Nel mondo digitale, non è possibile non intervenire in alcun modo su un RAW, e non sono neppure comparabili i risultati che si ottengono sviluppandolo “a zero” con software diversi: i dati sono soggetti a interpretazione e ogni modulo di sviluppo ha la propria idea su quale sia l’interpretazione di base più giusta. L’apertura “a zero” in Camera Raw non è identica a quella che otterremmo in Capture One o DxO Optics Pro. Resta l’opzione di scattare in JPEG. Ma anche qui: quale JPEG?

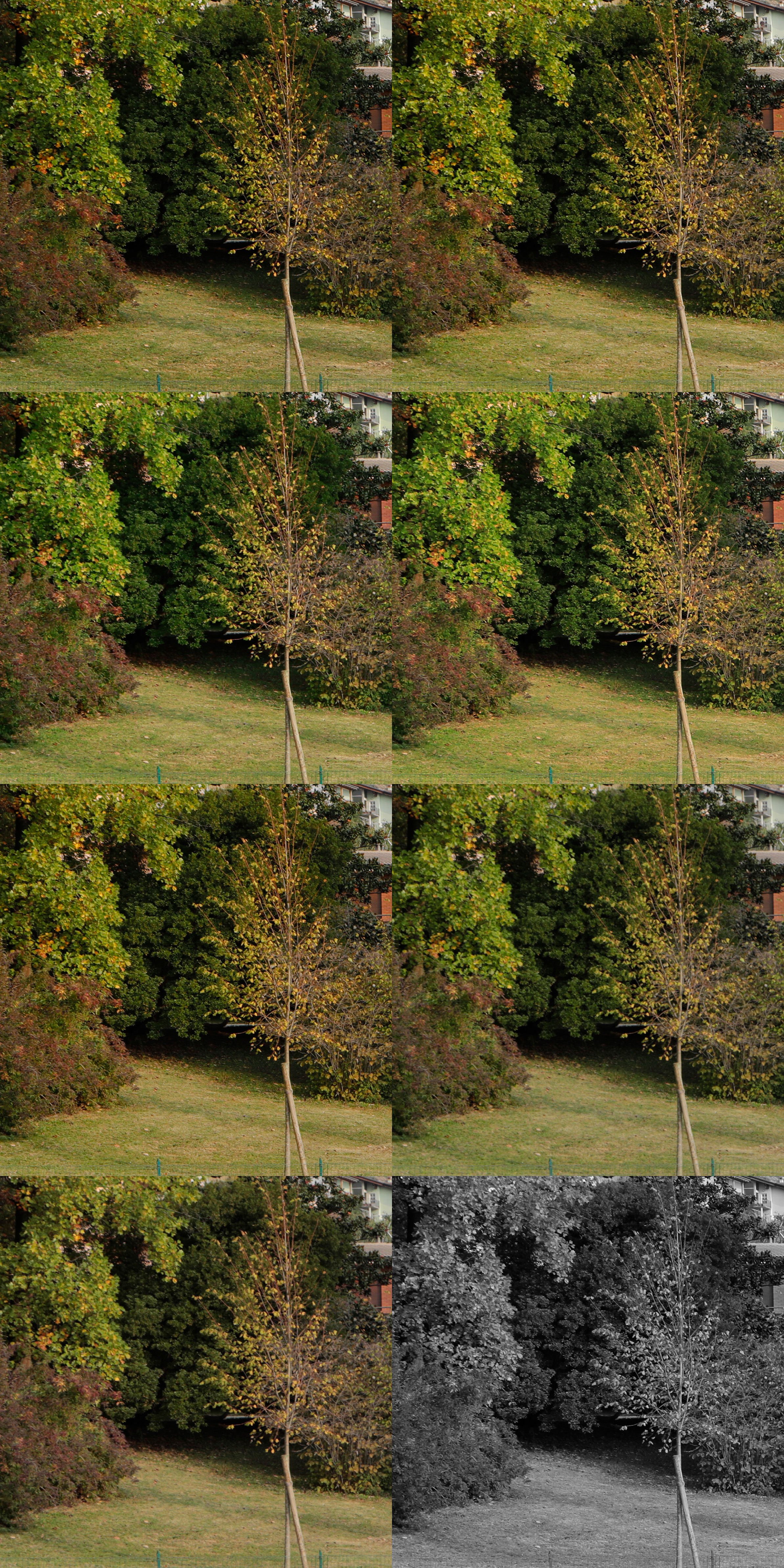

Il collage qui sopra è molto grande: potete cliccare per ingrandirlo e anche scaricarlo, se volete. Riproduce lo stesso dettaglio tratto da otto fotografie diverse scattate in JPEG. Le condizioni di ripresa sono identiche e nessuna post-produzione è stata effettuata in Photoshop: ho aperto le immagini originali, le ho allineate, ritagliate, distribuite e ho salvato il risultato. A parte quella in basso a destra, le differenze tra le altre sette sono notevoli. A titolo di esempio potete confrontare la definizione della terza fotografia a sinistra (dall’alto) con quella sottostante, nella versione a grandezza naturale: la variazione è tutt’altro che secondaria.

Che differenze passano tra queste versioni? Partendo dalla prima in alto a sinistra e procedendo orizzontalmente per poi scendere, i loro nomi sono: Auto, Standard, Ritratto, Paesaggio, Dettaglio fine, Neutro, Immagine fedele, Monocromo. Sono gli otto Picture Style standard della mia Canon 5D Mk IV. Quale di questi JPEG è “giusto”? Bisognerebbe capire rispetto a cosa: affermare che una cosa è “giusta” o “corretta” implica che abbiamo in mente un riferimento. Dal mio punto di vista, sono tutti potenzialmente giusti e tutti potenzialmente sbagliati. Qual è il riferimento? La realtà, forse, come la vediamo? Non ne sarei così sicuro. Voi ne sareste sicuri? Davvero riuscite a esserne sicuri?

Nel dubbio, sospendo il giudizio. Ma di una cosa sono certo: la frase “Nessuna post-produzione” è un ossimoro, una contraddizione in termini. Qualsiasi cosa facciamo dopo avere scattato (e talvolta anche prima) influenza in maniera più o meno prevedibile il risultato. E questa è, piaccia o no, una forma di post-produzione. Fotografare dei paesaggi in JPEG selezionando il Picture Style Paesaggio implica che desideriamo avere variazione cromatica, soprattutto nei verdi, e maggiore saturazione: non ci chiediamo se i colori o i rapporti tonali siano “giusti”. Operiamo una scelta a priori. È post-produzione preventiva, insomma.

Anche se scattassimo in RAW, le cose non cambierebbero. Dobbiamo per forza scegliere un set di parametri. Se decidessimo di non toccare nulla in Camera Raw, delegheremmo le scelte di post-produzione ai programmatori Adobe, ma non otterremmo qualcosa di “intatto”, tantomeno di assoluto. Otterremmo solo una delle infinite versioni possibili di una fotografia.

Chiudo con uno spunto di riflessione: ecco che cosa pensa una fotocamera quando le chiediamo di scattare una foto “neutra” piuttosto che in modalità “paesaggio”.

Questo è un affiancamento, non un collage, tratto dalla stessa serie di fotografie che hanno prodotto il collage visto prima. Davvero siete così sicuri che non stiamo post-producendo, anche solo inconsciamente, quando scattiamo in JPEG? Ai posteri. Ne parleremo.

MO

Complimenti per l’articolo: chiaro, lucido ed interessante!

Grazie mille, Luca!

Ciao Marco, mi puoi dire cosa bisogna fare per commentare questo articolo? Cmq ti volevo fare i complimenti e metterti un 10 e lode.

Grazie dell’apprezzamento, davvero. Penso semplicemente che ci vorrebbe un po’ di ragionevolezza e senso del reale – e spesso mi sembra che manchi.

Un saluto,

MO

non ho capito a cosa ti riferisci quando dici:

Penso semplicemente che ci vorrebbe un po’ di ragionevolezza e senso del reale – e spesso mi sembra che manchi.

Mi riferisco al fatto che vedo fotografie fatte a caso spacciate per arte, persone che pensano di conoscere la post-produzione perché riescono a spostare alcuni cursori, immagini false e realizzate tecnicamente male prendere diecimila cuoricini su Instagram perché “emozionano”. Se si accettasse almeno in linea di principio che due secoli di storia della fotografia hanno costruito linguaggi, generato mondi ideali, influito talvolta in maniera incisiva sulla storia stessa della nostra razza… credo che ci sarebbe più umiltà e un approccio diverso, e non assisteremmo al terribile appiattimento di questo mezzo di comunicazione, che ha raggiunto livelli ridicoli. Ma naturalmente tutto questo è semplicemente idealistico, perché non sembra esserci limite all’incapacità di distinguere il valore dal nulla.

In questo senso, un approccio meno arrogante e più cosciente verso lo stato di cose che si è creato potrebbe fare solo del bene.

A presto,

MO

L’ho scritto dove ho trovato il tuo articolo e lo riscrivo anche qua: ti darei il Nobel per la fotografia (ci fosse !!!).

Mioddio, Alberto: temo che lo spirito di Bob Dylan s’impadronirebbe di me, in quel caso :).

Scherzi a parte, grazie – ma cerco solo di fare dei discorsi razionali su temi oggettivamente complicati, sperando che a qualcuno servano come spunti di riflessione. Se è così, lo scopo è raggiunto.

A presto,

MO

🙂 E’ proprio per questo motivo che apprezzo ciò che scrivi e credo che lo scopo sia completamente raggiunto. Ripensandoci bene credo che dovrebbero assegnarti il Nobel per la “filosofia fotografica”. Grazie per quello che fai. Alberto.

Grandissimo articolo.

Facile da leggere e molto chiaro!!

Grazie mille, Enrico!

MO

Interessantissimo e la tesi che nessun mezzo di riproduzione della “realtà” rappresenti in assoluto la realtà equivale a sostenere quanto siamo limitati nella conoscenza del mondo che ci circonda. Già la meccanica quantistica aveva demolito molte teorie assolutistiche a tal proposito. Un mio amico tuttavia sostiene che esiste un diverso “grado” di post-produzione tra analogico e digitale . Nel primo caso intervengono pochi elementi rispetto al secondo che pertanto offre risultanze più pesanti. Mi chiedo se è giusto ragionare in termini quantitativi ignorando l’aspetto qualitativo. In sostanza la carta è stato un elemento determinante per la stampa in analogico ma nel digitale intervengono una serie di elementi che caratterizzeranno il risultato. La conclusione è dunque: nel digitale la post-produzione (mi riferisco a quella “preventiva”) “pesa” di più rispetto all’analogico?

Ho qualche dubbio.

Mi fa piacere rileggerti dopo tanto tempo, un cordiale saluto

Giuseppe

Grazie, Giuseppe. Non so se esista una risposta: quello che è certo è che il digitale è enormemente più facile da manipolare dell’analogico, e questo vale non solo in campo fotografico. Penso che il peso delle cose sia in larga parte quello che gli diamo, però. A ben guardare anche generalizzare il termine “analogico” è sbagliato: sviluppando un negativo in bianco e nero la gamma di possibilità di scelta era enorme – si potevano provare diluizioni diverse dei chimici, formule strambe e via dicendo. Nel colore, questo margine si riduceva sensibilmente – a meno di non voler uscire deliberatamente dai binari e ottenere dei “chimigrammi” piuttosto che delle “fotografie”. Se poi utilizzavi Kodachrome, il processo non era accessibile perché poteva svolgerlo solo Kodak. E anche lì, nascevano delle nicchie: un fotografo una volta mi disse che il suo riferimento personale era il Kodachrome 25, ma solo se sviluppato nel tale laboratorio di Los Angeles, perché – etc. etc. etc. Quindi, una gamma variabile di opzioni, anche lì.

Quello che so è che mi piacerebbe vedere più fotografia, intesa nel senso di “immagini non stravolte”, di quanta ne veda intorno – ma qui si apre un altro capitolo che è probabilmente senza fondo. Per il momento, ne resto volentieri fuori :).

A presto e grazie ancora,

MO

Una grande lezione che chiarisce molti dubbi. Moltissimi fotografi digitali dovrebbero seguirti più spesso per imparare davvero, anziché parlare, spesso, a vanvera.

Grazie, Cesare. Sai dove sta il problema? Questa materia è difficile. Non è semplice spiegare le cose e restare abbastanza vicini a terra da farle capire a chi magari non si trova bene in mezzo a questioni troppo tecniche. A volte si fanno dei cortocircuiti e si tira diritto: talvolta in buona fede, talvolta no. Il risultato è che i concetti passano in maniera storta. Io cerco solo, per quel che posso, di restare abbastanza nel sentiero pur sapendo che è strettissimo. E poi, si sa: alcuni per un obiettivo spendono €2000 senza problemi, ma pensano che per un libro serio €20 siano troppi. Una stortura, ma siamo abituati così – senza voler generalizzare, naturalmente.

A presto!

MO

Grande Marco!!!

Dovrebbero impararlo a memoria tutti i cosiddetti puristi della fotografia

Grazie a te del commento.

A presto!

MO

Come sempre molto chiari e interessanti i tuoi articoli, è un piacere leggerti e condividere quello che scrivi.

Un saluto e grazie ancora.

Olmo

Grazie mille, Olmo.

A presto,

MO

Bravissimo!!!

come sempre i tuoi articoli sono perle da leggere e conservare per capire la fotografia digitale..

Permettimi uno sfogo….

Io vengo dall’analogico (non sono un professionista ..solo .. un appassionato ) e l’ho abbandonato solo per la grande comodita’ del digitale..che non riesco ad amare fino in fondo… “forse” perche’ non sono molto esperto di post produzione digitale ..ho nostalgia delle foto fatte con la Rollei SL66 e Leica che stampavo su Galerie o Brovira .. o su Cibacrome Sig!!

Mi sembra …da profano.. che una differenza tra i digitale ed analogico, che mi fa avere nostalgia, sia anche dovuta al comportamento diverso del sensore che e’ “sostanzialmente ” lineare e “taglia” agli estremi luci ed ombre mentre la pellicola –se ben esposta e sviluppata–( ricordo con nostalgia Emofin a due bagni) grazie al piede ed alla spalla della curva comprimeva con un andamento asisntotico –senza tagliare “crudemente”– gli estremi di luci ed ombre e dava quell’effetto plastico che hanno le immagini analogiche (o forse e’ solo nostalgia—bohh.) e forse i futuri sensori con latitudine molto ampia renderanno trascurabile questo aspetto.

Sono poi un nemico dello sharpening (forse anche qui perche’ sono un dilettante nonostante usi -poco- lo sharpening di Margulis) che fa sembrare i piani a fuoco “incollati” sulla parte di background facendo sembrare innaturali molte foto. (ho visto la mostra di Salgado: Genesis e si vedeva chiaramente la differenza tra le foto fatte con Leica quelle con Pentax 4*5–fantastiche — e quelle digitali …molte di queste ultime esasperate nei dettagli e non piacevoli …almeno secondo il mio gusto)

Stessa sensazione di “esagerazione ” di ipersaturazione e troppo sharpening nelle foto si Steve Mc Curry….

mi scuso se mi sono dilungato troppo

p.s. una domanda se non abuso troppo della tua pazienza ..ma da nostalgico ….dove si trova una “trattazione/parallelo” del metodo Zonale in ambito Digitale?

ciao e buona serata,

p.s.2 —dopo i tuoi consigli .. ho appena ordinato un EIZO CG2420 ..sono ansioso di provarlo

Enrico

Enrico, io ho letto “The Practical Zone System for Film and Digital Photography” di Chris Johnson (lo trovi su Amazon anche in formato Kindle) e non mi è dispiaciuto. In realtà, i principi sono quelli, poi ci sono diversi modi di applicarli.

Quanto alla questione pellicola vs. sensore, a mio parere il problema non è tanto nelle curve sensitometriche che, come dici, hanno un piede e una spalla piuttosto morbidi; quanto nel fatto che il sensore cattura la luminanza di una scena mentre la pellicola cattura la chiarezza. Nei due casi, la distribuzione dei grigi è molto diversa, e il sensore lavora meglio nelle luci che nelle ombre. Questa distribuzione, che sarebbe difficile da gestire se non venisse un po’ aggiustata, subisce una ristrutturazione per mezzo delle curve gamma, ben note. Poi… quale sia il risultato “migliore” francamente non lo so dire. Dipende molto dal gusto, dal genere fotografico – troppi fattori per dare una risposta.

Un saluto!

MO

Grazie, interessante e comprensibile anche ad un amatore fotografo come me.

Nerella

Grazie mille, Nerella!

A presto,

MO

grande Mo….io mi sono stancato di ripetere queste cose a lezione…ancora e ancora, come la storia dei ppi…e mi chiedo come sia possibile, dopo anni di corsi e lezioni di tanta gente brava, che diffonde il verbo, che ancora non ci siano le idee chiare…

secondo me ci vuole una religione: fotografesimo

lol

Le religioni le eviterei, ne abbiamo già abbastanza :).

La questione che sollevi è spinosa. Ovviamente nessuno è infallibile, ma è un dato di fatto che ci sono – in mezzo a tanti docenti e divulgatori bravi – anche diverse persone che fanno parecchio casino e hanno una visibilità elevata. Sai bene che fare casino con una visibilità elevata è dannoso, anche perché un seguito grosso dà fiducia. Non rivendico nulla e non mi va di fare nomi e cognomi, ma non tutta la didattica è fatta bene, e lo sai meglio di me. Grazie invece per la tua opera, che conosco bene.

Un caro saluto,

MO

Fortunatamente non ho mai incontrato nessuno del ” polo di puristi che rifiutano la post-produzione per ragioni filosofiche e affermano che la fotografia è solo quella prodotta dalla fotocamera, così come sta.”

Messa così i puristi non hanno veramente capito nulla ,come spieghi benissimo nell’articolo, ma forse qualcuno vuole intendere che anche solo una minima post produzione ,e a maggior ragione l’eccesso di questa dopo lo scatto ,sia da evitare.

In pratica scegli il sensore e non tocchi più nulla ( e qualcuno di questi l’ho conosciuto).

Non vedo il motivo per pensare così.

Io stampavo in bianco e nero e ” mascherare” era normale.

Ancora prima di entrare in camera oscura ,tipo di pellicola e sviluppo determinavano un carattere dell’immagine.

Personalmente penso che la post produzione sia un vantaggio.

Quel che conta è il risultato finale , poi a chi guarda spetta valutare….sempre che interessi all’autore…

Un saluto

Gianni

Ottima sintesi, Gianni – grazie!

A presto,

MO

Bellissimo articolo, con molti spunti di riflessione!

Well done!

Grazie mille, Paolo!

Molto interessante, Marco. Mi è piaciuto molto il richiamo, il ricordo che hai avuto per Ansel Adams. Ai miei tempi…, usando la Silvestri, scattavo sempre tenendo presente i suoi insegnamenti. Grazie infinite.

Grazie mille a te, Pino – a presto.

MO

Buongiorno Marco.

L’articolo é di un anno fa ma é vivissimo e denso, leggerlo una volta sola non basta.

La mia fotografia, prettamente amatoriale e di livello spero almeno nella media, si e’ fermata con le diapositive, per vari motivi non sono mai passato al digitale, semplicemente ho smesso di fotografare.

Mi diletto ( e “diletto ” é la definizione esatta, nulla di piú ) col mio archivio di diapositive, facendone scansione di quando in quando, un giorno avró finito forse… FS4000US finché dura, poi ci penseró.

C’é una cosa che mi sono spesso chiesto: quando ottengo la mia bella scansione sul monitor faccio di tutto perche’ sia il piú possibile “uguale” all’ originale proiettato, non piu’ satura, non piú calda, non piú fredda…. tieni conto che per sistemarla osservo l’originale proiettato in quel preciso momento, mentre ho la scansione a video.

Quando scattavo non amavo molto la sottoesposizione di un terzo o due fatta apposta, il polarizzatore ce l’avevo ma se lo usavo tornavo sempre indietro di almeno un quarto di giro per non effettare troppo.

E’ giusto? E’ sbagliato? e’ uno dei 100 modi in cui ognuno é libero di pensarla?

E’ questo che mi chiedo spesso. L’aspetto dei miei volti o delle mie dune del deserto e cosi’ via faccio in modo che somigli il piú possibile alla diapositiva vera, che e’ l’immagine del ricordo che ho negli occhi.

Il mio indirizzo email rivela quale sia stata e quale sia tuttora la mia passione.

Cosa vale tutto questo nel mondo professionale?

Mille grazie per ogni articolo che scrivi e cordiali saluti.

Paolo

Che bel commento, Paolo – grazie. Direi che sì, “è uno dei cento modi in cui ognuno è libero di pensarla”. Ci sono contesti in cui una riproduzione accurata del colore originale è cruciale, altri in cui il margine creativo è notevole, altri in cui sembrano non esserci limiti. Penso che il problema sia voler ridurre a tutti i costi la parola “colore” a qualcosa che indica un concetto, mentre in realtà il termine si riferisce a un mix così complicato di fenomeni fisici e percettivi da risultare quasi incomprensibile nella sua essenza.

Io credo che alla fine la cosa migliore sia essere soddisfatti di ciò che si fa; se poi questo viene apprezzato anche da terzi, meglio ancora. Alla fine, però, spesso facciamo le cose… perché vogliamo farle, e quindi via libera a ciò che più ci aggrada.

Un caro saluto, a presto!

MO

Buongiorno, trovo interessantissimo e soprattutto utilissimo questo articolo!

Grande chiarezza, anche sull’argomento “apertura zero” dei vari software…cosa tutt’altro che scontata.

Mi chiedevi se potessi chiederle un parere, su una cosa che ho notato ieri facendo post-produzione di alcuni miei scatti RAW. Utilizzo al momento il software nativo di Nikon, NX-D. volevo convertire poi i file in JPG alta qualità, e mi sono accorto (per la prima volta) che nei JPG i colori sono stati spesso “stravolti” rispetto a come li vedevo al termine della lavorazione RAW sullo schermo. Saprebbe darmi qualche suggerimento e/o ipotesi di spiegazione?

La ringrazio anticipatamente, Stefano Fantini

Stefano, perdona innanzitutto l’enorme ritardo con cui rispondo. Un mese è un tempo imbarazzante, mi rendo conto.

Non sono certo di avere capito il problema, ma credo che sia questo: quando fai la post-produzione del RAW vedi una certa cosa a monitor. Quando poi esporti il jpeg vedi una cosa diversa. Suppongo che questa discrepanza avvenga quando osservi l’immagine in altri visualizzatori.

A priori è impossibile dire quale sia il motivo, ma la causa più comune risiede in una compensazione a monitor che non viene fatta – o viene fatta male. Per compensazione a monitor intendo: la conversione dei numeri originali della foto in altri, in maniera che il significato originale venga preservato quando le immagini vengono visualizzate su uno schermo che, a priori, potrebbe essere diverso da quello su cui si è lavorato in origine.

Il compito di applicare la compensazione a monitor è in capo al software di visualizzazione. Alcuni software (ad esempio: il visualizzatore immagini di Windows) ignorano completamente la compensazione. In pratica, leggono i valori dell’immagine e si limitano a “incollarli” così come stanno sul monitor. Photoshop, se opportunamente impostato, si comporta invece diversamente – nel modo giusto. Anteprima su Mac, per fare un altro esempio, non dà problemi. I browser… dipende. Nella gran parte dei casi, ormai, la compensazione avviene – ma non sempre. Lo scenario, quindi, è abbastanza complicato.

Nel caso si abbia la certezza che la gestione del colore (perché di questo si tratta) venga fatta in modo corretto, il problema potrebbe risalire a qualche preferenza corrotta nel software di sviluppo. In quel caso, un reset generale delle preferenze di solito risolve il problema. In caso contrario… si indaga un pezzetto alla volta, fino alla rimozione e re-installazione del software. Però una prova che varrebbe la pena di fare è questa: se l’apertura del file in Photoshop, con rispetto del profilo incorporato, mostra l’immagine corretta – ovvero come quella in NX-D, significa che tutto funziona probabilmente a dovere. A quel punto la causa è – come suggerivo – da ricercare nel visualizzatore che si usa di solito, o in altri problemi a livello di sistema. Su Windows, in generale, ACDSee è un buon software di visualizzazione, che funziona meglio del modulo nativo fornito da Microsoft e che molti utilizzano proprio per questa ragione.

Un saluto e a presto!

MO